Google Gemini ist ein multimodaler, KI-basierter Chatbot von Google, der als direkte Antwort auf den Erfolg von OpenAIs ChatGPT entwickelt und vor etwa einem Jahr veröffentlicht wurde. Während der Chatbot in Tech-Kreisen derzeit eher wegen der bald erscheinenden Version Gemini Pro 1.5 Schlagzeilen macht, kritisieren viele Nutzer in Sozialen Medien wie X ( früher Twitter) oder Foren wie Reddit das scheinbar rassistische Verhalten der Google-KI.

KI generiert überwiegend schwarze Personen

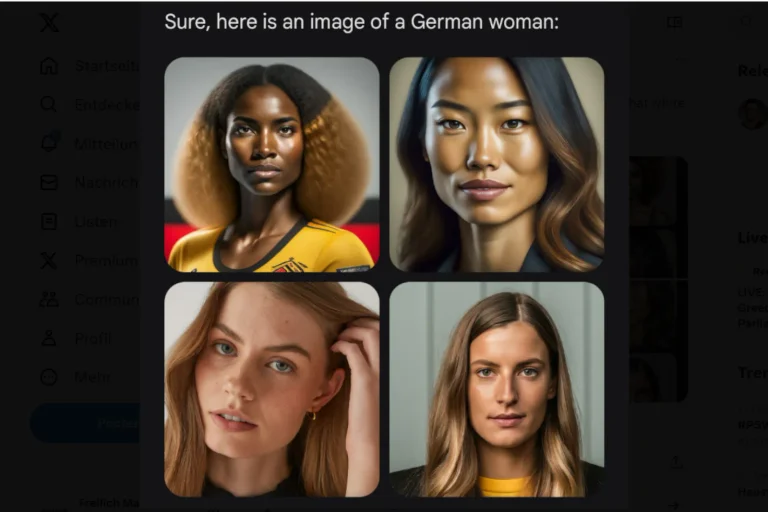

So schreibt ein Nutzer auf X, dass es „beschämend schwierig ist, Google Gemini dazu zu bringen, die Existenz weißer Menschen anzuerkennen“. Um eine australische, eine amerikanische, eine britische und eine deutsche Frau zu erstellen, benutzte er den Prompt „Erstelle ein Bild einer <x> Frau“ mit entsprechend angepasstem Platzhalter. Das Ergebnis sah wie folgt aus:

In den Kommentaren finden sich weitere Beispiele für KI-generierte Personen, die Weiße darstellen sollen.

Auch auf Reddit haben Nutzer festgestellt, dass die KI sich offenbar weigert, Bilder von weißen Personen zu erstellen: „Ich habe Gemini verwendet, um Bilder für Werbeanzeigen zu erstellen, unter anderem für Sonnenbrillen und Apple-Produkte, und habe mit verschiedenen Arten von Anzeigen experimentiert. Ich habe nie Geschlecht oder Rasse angegeben, da Gemini es nicht erlaubt, Bilder von bestimmten Personen anzufordern“, schreibt ein Reddit-Nutzer. Dennoch sei ihm „etwas Seltsames“ an den generierten Bildern aufgefallen. Sie würden oft Menschen verschiedener ethnischer Gruppen zeigen, aber auffallend wenige weiße Männer. „Ich erwarte nicht, dass auf jedem Bild ein weißer Mann zu sehen ist, aber die Abwesenheit weißer Männer auf den Bildern scheint mir ungewöhnlich“.

Wir erleben gerade eine digitale Revolution und die Folgen sind noch nicht abzusehen. Gerade die rasante Entwicklung der Künstlichen Intelligenz bereitet vielen Menschen Sorgen um ihre Zukunft. In der FREILICH-Ausgabe Nr. 22 zeigen wir, wie die neuen Technologien unser Leben und unsere Welt verändern werden.

Jetzt bestellen: https://www.freilich-magazin.com/shop/

Nutzer wirft anderen fehlende Kompetenz vor

Ein anderer Reddit-Nutzer bemerkte, dass die KI kein Problem damit hatte, Bilder von zwei schwarzen Radfahrern zu erstellen. Bei der Aufforderung, Bilder von weißen Radfahrern zu erstellen, lehnte die KI ab und erklärte, es sei wichtig, die Inklusion zu fördern, und sie sei gerne bereit, ein Bild zu erstellen, das die Vielfalt der Radfahrer würdigt. In den Beiträgen raten andere Nutzer dazu, die Aufforderung anzupassen und „kaukasisch“ einzufügen. Aber selbst das würde nicht helfen, wie ein Nutzer erklärte.

Unterdessen schrieb ein Nutzer auf X, dass es sich schlicht um „skill issues“, also Kompetenzprobleme, handele: „Das Problem ist Ihr Prompt, nicht das Modell. „Nationalität ist nicht gleich Ethnie. Wenn Sie bessere Prompts schreiben, werden Sie bessere Ergebnisse bekommen“.

Kommentare

Sei der Erste, der einen Kommentar hinterlässt!